- 近期网站停站换新具体说明

- 按以上说明时间,延期一周至网站时间26-27左右。具体实施前两天会在此提前通知具体实施时间

主题:【原创】AI对人类社会影响能有多大? -- 真理

当过了一个阈值,AI自然而然的自动进化下去,如果人类想阻挡,就践踏人类进化而去。

所以将来的人类最好的结果是成为AI用来仿生的一种保护动物,AI向宇宙进军。地球最好的结果就是成为人类的圈养区。

所以俺认为是3

不过是肾上腺,dopamine,serotonin,各种荷尔蒙与只能化学信号的作用结果,进化出这些的目的是动物智能在有限能耗下的功效有关的,比如动物至少灵长类动物普遍具备情感能力。 比如都知道人记不住过去事情的细节,法庭上闹笑话常有,但是人永远不会忘记当时的情绪感受,所以第一眼的感觉决定一切,所谓直觉,所谓屁股,所谓白左最反对的按照肤色人种定性,其实都是人脑智能的天生一部分。 说起来与九段们看围棋是一回事,九段们当然无法计算到未来的所有每一步,就是一种艺术么,直到遇到了阿尔法狗。

你对人过于吹捧了,这是文艺复兴时候为了对抗宗教势力的权宜之计。人本身比猿猴聪明些,但有限。

chatGPT是一个语言模型,如果有困惑把这句话重复十遍,困惑就解决了。

柏拉图说过,人类的感情(感性)就像拉车的马,为人类的行为提供动力,而人类的理性则为行动提供方向

柏拉图的年代,能量守恒都不知道,基本的动力学都不知道。他下意识地认为,改变方向不需要多少能量(到二十世纪还是这样,武侠常见四两拨千斤),还有情感冲动提供能量,今天我们知道那点冲动是不够的,能量还是来自于吃饭。但是柏拉图不知道氧化还原反应啊。

所以他这一段话,根本就是不知所谓。你还是不要引用的好。这些古代哲人的朴素思想,太过原始,拿来讨论人工智能的问题,怎么说呢,比相声里说的,火箭烧汽油柴油还不靠谱。汽油跟火箭技术不过差两三百年,柏拉图和人工智能差了两三千年,他有什么资格说话?

如果对于自然的深邃有兴趣,希望投身于纯粹的科学本身(而不是附加的名利),这样的人尤其在二十岁的年龄,肯定有,而且不少。

但是他们会选择数学或者物理,甚至计算机,极少数化学或者经济学。选生物的么,呵呵,跟文科差不多,死记硬背多,思考少。

其实教育行业类似健身教练,主要还是督促。否则你学生不听讲,人工智能还能骂他不成?惩罚机制如何建立?请家长?

要是把一个学生逼得,不要说跳楼,哪怕抑郁症了,那肯定又要全面禁止了。这可不比人类教师,学生跳楼就是停职一个,学校都不会停课。要是人工智能教师呢,哼哼,最轻也是温州动车事故那种,几年重启不了。

类似的医疗行业,医生可以代替,护士只怕很难。

可能是上了某些新闻标题的当吧

原文是这样的:

7月6日,2023 世界人工智能大会开幕式上,2018 年图灵奖得主、Meta AI基础人工智能研究院团队首席人工智能科学家杨立昆(Yann LeCun)直言,不喜欢AGI(通用人工智能)这个名词。

他解释称,每一个智能都是专项的,人类智能也是非常专业、专项的,但LLM(大语言模型)只基于文本训练,不是利用视频训练,因此它们不理解物理世界,没办法规划、推理,就没办法实现目标。

在近期关于AGI的辩论中,杨立昆多次表示,类ChatGPT产品并不能真正理解现实世界,更无从谈起实现人类智慧。

杨立昆认为,现在还没有一个足够智能的系统来处理各种事情,所以人工智能系统需要一个世界模型(World Model),这个模型主要通过观察来训练,并通过少量交互处理不确定性。

对于如何实现AI的治理和规范,杨立昆称,他认为可以通过可控的方法,设置安全护栏等使它们不会出现欺骗和支配人们的行为。

杨立昆最后表示,他完全不同意“因为任何人可用人工智能做任何事,情况可能会非常危险,所以需要严格监管人工智能”的说法。

他认为,严格监管人工智能发展并不能保证AI安全,长远看开源才能让AI保持安全、良善。

如他所说,他只说了ChatGPT这类语言模型的局限,而不是说人工智能整体的局限。实际上,他说的“人工智能系统需要一个世界模型(World Model),这个模型主要通过观察来训练”,刚刚已经出现了。

斯坦福的李飞飞团队刚刚发布了新的机器人,这个机器人同时接入了ChatGPT语言模型和Midjourney视觉模型,可以不经训练直接执行人的指令。比如打开抽屉,拿起手机,关门等。机器人可以自行理解人的指令,并且从周遭空间中认出相应的物体加以操作。

未来已经到来,我们的区别只在于什么时候认识到这一点。

但和其他物种比可一点都不低。

大脑,可以说是人体最奇妙的器官了。

它重3斤左右,仅占人体重的2%,但是它消耗的能量却占人体的20%。

恐龙用了一亿多年也没进化出这样的大脑。人的大脑在进化上看已经相当极端了,如果没有额外的好处早就被进化淘汰了。

人类大脑中负责“理性”的部分十分小,基本上只在皮层的前额叶中。前额叶受损的人,非常容易情绪失控,且“道德感”很弱。而大脑剩下的大部分可以看成是“感性”的。

而且前额叶使用的并没有想象中的那么多,人一般只有在积极思考的时候才主动使用,其他的时候会使用更快,更节省资源的“直觉”,也就是“感性”来处理。还有人类往往会把通过前额叶学会的技能“固化”在其他部分,进而形成类似“肌肉记忆”之类的东西。比如人学走路,骑自行车等,在开始的时候会主动学习,会了以后就不用思考也能走路骑自行车了。而运动员,武术家反复训练的目的也在于让身体不经过"大脑"(实际上是前额叶)就可以对各种情况作出反应。

还有睡觉的时候大脑其实也在工作,从短期记忆到长期记忆主要就是在这时候做的,而这也不需要“理性”主动参与。

“理性”这部分大脑最大的好处其实是使人类之间的沟通,使人类之间的经验可以共享。反过来前额叶也需要这种沟通才能完全成熟,最新的研究表明要到25左右。(人年轻的时候容易冲动也可以用这个解释)

除了通过前额叶,大脑还可以通过其它方式“编程”,催眠就是其中常见的一种,而近来很多人将催眠视为更广泛的NLP(Neuro-Linguistic Programming,神经语言程序学)的一种。

柏拉图这段话只是比喻(或预言),虽然时间很长了,但可是并不“过时”。这里强调的不是谁大谁小或者谁更重要,而是说没有“理性”引导的“感性”是盲目的。

当然这个比喻确实有“感性”力量大于“理性”的意思,而这也和现代科学不违背:人用来处理“理性”的部分-大脑皮层前额叶-确实只占大脑和身体的一小部分。

《影响力》这本书说的基本就是怎样防止这种别人利用这种盲目“控制”自己,《瞬变》则化用了比喻,用大象代替了马,而整本书讲的是怎样主动利用“感性”来让别人做希望他们做的事情。

而且谈到AI能不能产生强智能,还真绕不过柏拉图。AI能不能产生强智能,本质上就是AI能不能产生人类的“心”的问题。而这个问题和柏拉图这个唯心主义哲学大师关系还不是一般的大。

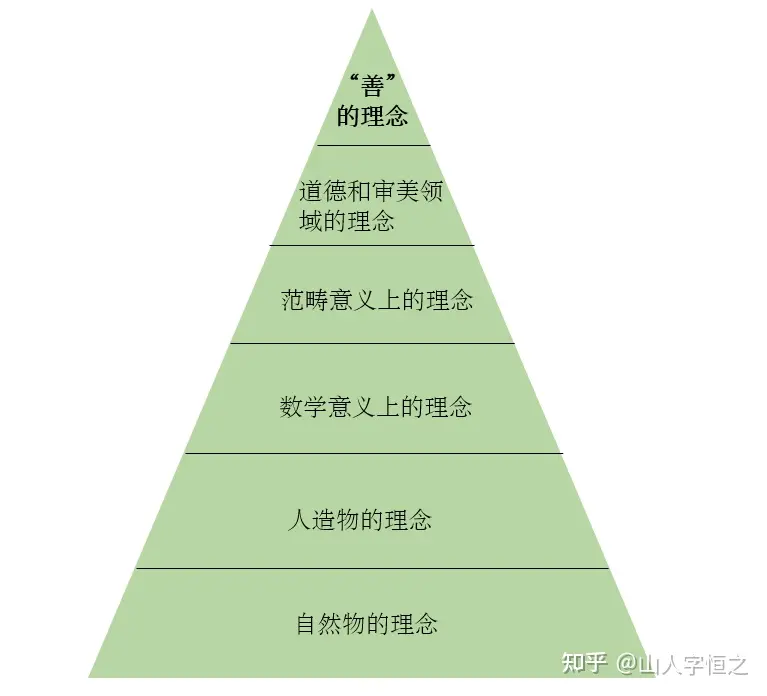

罗翔说北大图书馆借阅量第一的是《明朝那些事儿》,而美国大学生借阅量第一的是《理想国》。在这本书中柏拉图提到了“抽象”和“理念”,而“理念”是“实在”的,其中就包括“数学意义上的理念”。

这个观点被哥德尔等人接受,对,就是提出“哥德尔不完全性定理“的那个哥德尔,王浩院士在《哥德尔》中提到:

哥德尔思想的发展虽然是个长篇的话题,但这里对其中主要之点略加提示,恐怕是不无裨益的。

1921年,一本微积分基础教程勾起了哥德尔对数学的兴趣。那年夏天,他读了一本歌德的传记,这又间接地引导他对牛顿的思想和一般物理学感起了兴趣。他1922年开始读康德。1924年,他入维也纳大学学习物理;但他对精确性的追求,引他出物理而入数学(1926年),进而达到数理逻辑(1928年)。从他的信中拾出的两则文字,谈了这一段时间里他发人深省的两件事,一是他早早就归附了柏拉图主义,一是他认为自己与当时的知识气氛格格不入。

1.3 大约从1925年起我就是一个概念和数学实在论者(1975年8月19日信,引自RG, p.20)。

1.4 我不认为我的工作是“20世纪早期学术气氛的一个侧面”,倒觉得正相反(同上)。

如果”数学概念“真的是”实在“的,那么就可以肯定以计算机为基础的AI永远不可能达到人的高度:人类能认识到某些”实在“且”不可计算“的数学概念但计算机永远不能。相反,如果想证明AI能达到人类的水平,那么也需要否认这些数学概念的实在性。

生物系的数学、物理课程不比计算机系少。死记硬背是数学物理之外的要求。拐玲能滑雪不意味着不能做题。考虑到颜宁的年龄,那会生物系招生正火,真爱的应该不少。

也就是跟所有本科生一样的大学物理基础课,数学老三篇:微积分线性代数概率统计,没了。

连化学内容也不多。我本科时候旁听过生物化学课,那就是大段大段文字,无方程无推导,这也是整个生物学的通病,到今天还根本没有解决。

在这种情况下,谈何揭开世界的奥秘?无非是头痛医头脚痛医脚,肤浅之极,如何能够吸引有才华的年轻人的热情?颜宁所谓生老病死的奥秘,跟选美小姐热爱世界和平有多少区别?

说句政治不正确的话,你只要看大学生物系有那么多女生,就知道这门学科离成熟还远着呢。

而是说没有 “理性” 引导的 “感性” 是盲目的。

是否盲目,定义就是是否符合理性,所以你这是同义反复,不能推导出新东西来。

你贴的柏拉图的抽象理念,自然物,人造物,数学,范畴,都没问题。再往上道德和美学意义,那就是胡扯了。这种论证方式在古希腊很常见,比如亚里士多德就把原因分解为四种。这些算是有益的古典哲学思辩,放到今天就太落后了,毕竟自然哲学已经改名叫物理学了。

最后,哥德尔怎么可能敢公开反对,道德啊,谁敢说这玩意儿根本不该放在这里?谁敢说道德只不过是人造物?社会舆论不骂死你。社会舆论不懂数学物理,但是他们懂道德啊。

对于这些Chat AI,如果有人只说好得很却不谈幻觉问题,我都会怀疑他到底深度用过这些Chat AI没有。不要用那些莫棱两可的、脑筋急转弯的问题和它们对话,这除了增加谈资,别无用处。要对话就在某个自己擅长的领域和Chat AI明明白白地交流。基本上都是还没碰到自己的边界,Chat AI就先出现幻觉了。

OpenAI公司认为需要5年解决幻觉问题,大家都很期待。我用Chat AI解释过算法,解释过数学公式,尝试设计过代码,也尝试重构过代码。无一例外,都碰到过丢失记忆和幻觉问题,都没有能完全地完成任务。我现在还把这些Chat AI当成一个有用的工具,但对话频次少很多。一般先用编辑软件里修改好问题后再对话,提示词尽力做到明确表述问题,每个可能不清楚地方都会有解释。对话一些内容后,感觉不对头就立刻停止,然后回头再一条条地验证,或者用google/bing来搜索。花费的时间不少,但总体比直接用google/bing来搜索文章后再理解的学习效率要高,相应的,单位时间里用脑程度也要高。

我现在都不敢让Chat AI提供相应的论文和参考项目了。论文或书籍的ISBN都能编造出来,网址也编出来,全是假的。AI法律助手也会碰到类似问题。一段信息,我们不知道AI是怎么分解形成链接并存储到哪里,也不知道再次聚合时AI会怎么做加工处理。将原有信息原原本本的输出反倒成了不确定的事情。很容易就发生张冠李戴,互相掺杂的问题。

前面那位“热河蛮子”河友解释得很好,要把Chat AI当成语文老师看待,而不能当成数学老师看待。我的经验,让Chat AI进行精确的符号推导确实有问题,包括编码也是类似问题,但是让它们用文字讲解基本的数学概念,错误的地方并不多。不过它们的输出内容和教科书的组织方式和关注侧重点也不一样,从来就不是教科书的复制。把它们当成语文老师,这就很容易理解了,它们是把相应知识进行内部“理解”后(所谓的“理解”,基本是根据大多数资料的概率分布进行组织),以它们的方式进行输出。因为自然语言的容错性或模糊性,我们会认为新组织的内容也表达了类似的意思,也是对的。但这时候想要像数学老师那样精确输出,进行精确的符号推导,就没有模糊性可言,这方面Chat AI就不擅长了,很容易就出错。类似地,不需要它们自己的“理解”,从链接里聚合原文并一字不错地输出,对它们也是困难的。以前读书时,哪位同学要是自己理解了,以自己的组织方式回答问题,而不是死记硬背,老师会直夸好好好。现在Chat AI的情况正好相反。

未来现在还没有来。先把眼前幻觉这道坎解决了,再谈下一步。 就目前的状况,是“文科生”有用还是“理科生”有用,还可以争吵5年。

如果看你最前面那个帖子的话,还以为是杨立昆说了这个“幻觉”的问题呢。然而他压根没有,你对他的话的解读也是错误的。这是不是你自己也产生了某种“幻觉”呢?

很显然,这种程度的“幻觉”对你不重要,对Open AI也不重要。既不影响你参加工作,也不影响人工智能应用到各行各业。至于什么是重要的,你回去再好好看看杨立坤说什么就行了。我上面已经贴出来了。